构建企业级RAG应用的文档解析与向量化能力

Deepseek的热潮让很多企业开始幻想:是否只要“接入一个大模型”,企业内部的知识就能被自动理解、调用,并转化为员工提效、客户服务、业务洞察的新动能?但很快现实泼了冷水——模型会“胡说八道”、答案“不靠谱”、问什么都在“打太极”。问题出在哪?

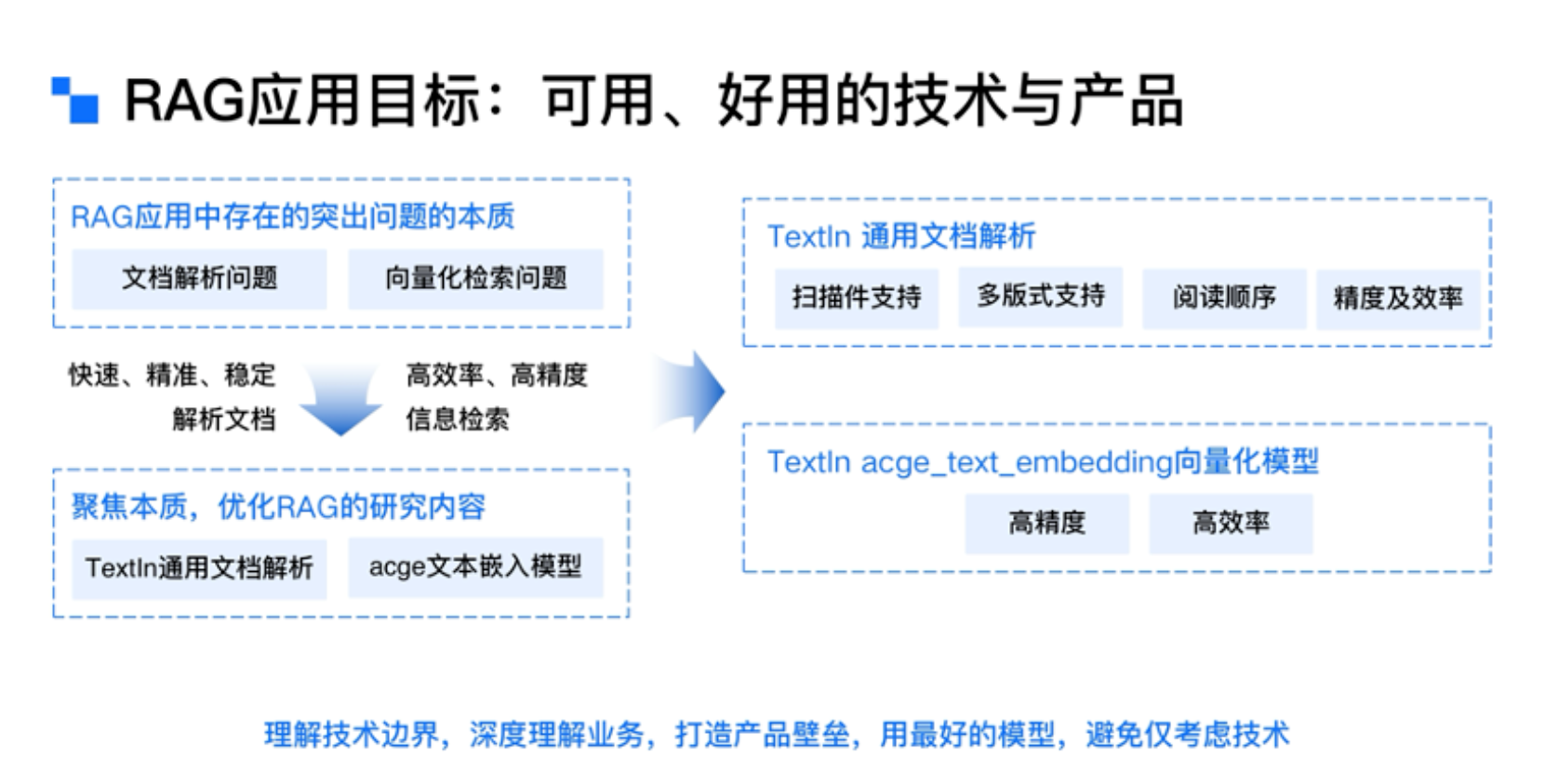

真正的难题并不在模型本身,而在于:它从哪里“读”到你要的知识?这便是RAG(Retrieval-Augmented Generation,检索增强生成)登场的意义——将企业私有知识通过检索方式引入大模型,辅助生成更专业、准确的回答。但要想真正跑通RAG,有两个至关重要的技术环节:文档解析与向量化。

01 | 文档解析:让大模型读懂人类知识

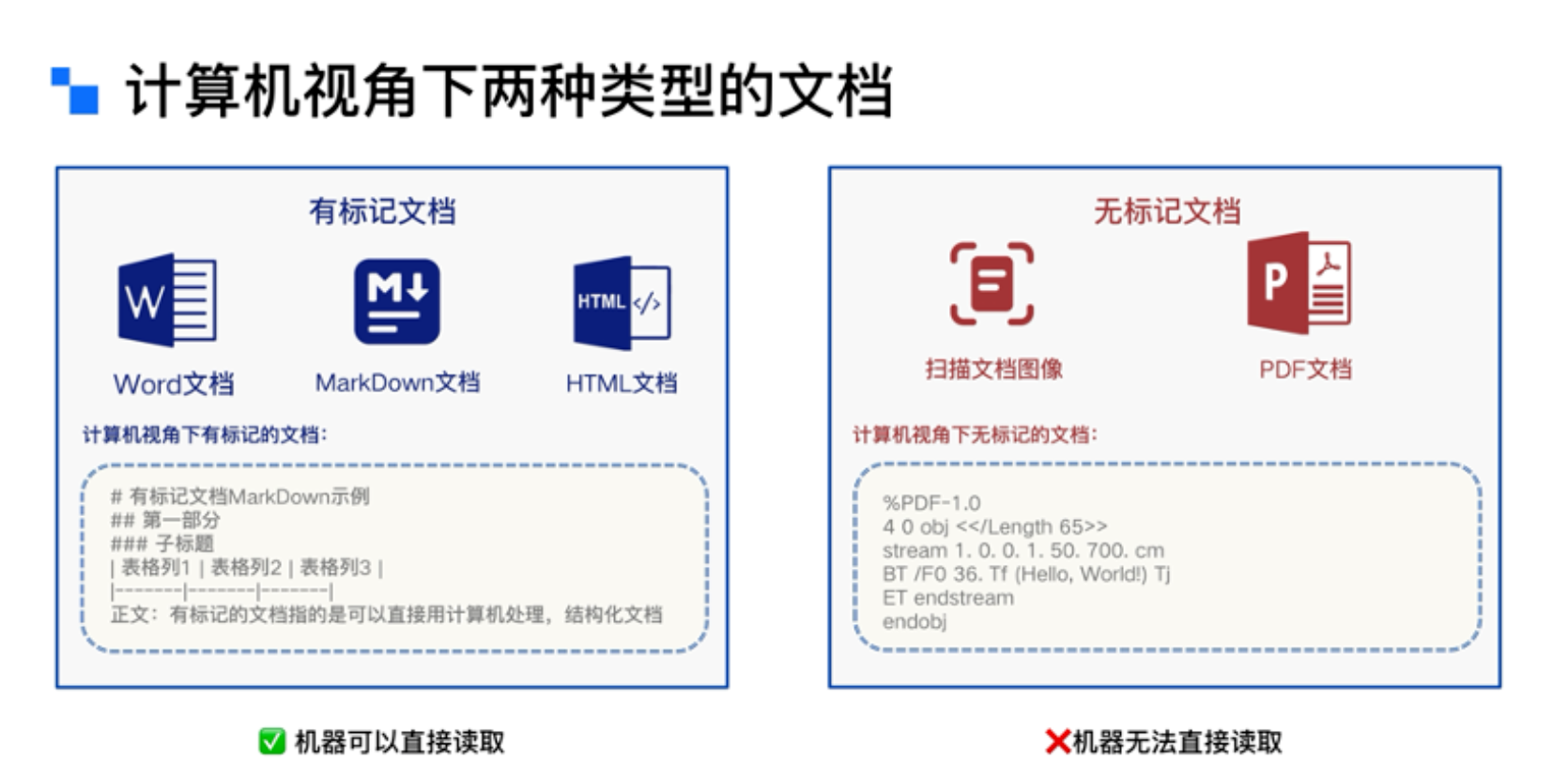

企业的知识不在数据库,而埋在成千上万份合同、报告、图纸、投标文档中。以日常办公中最常见的PDF文件为例,它并不是结构化格式,本质是一组排版指令的集合。在计算机眼中,一份PDF更像是一幅复杂的“图形海报”,而不是结构化的数据。想让大模型精准读取这些信息,第一步必须是高质量的文档解析。

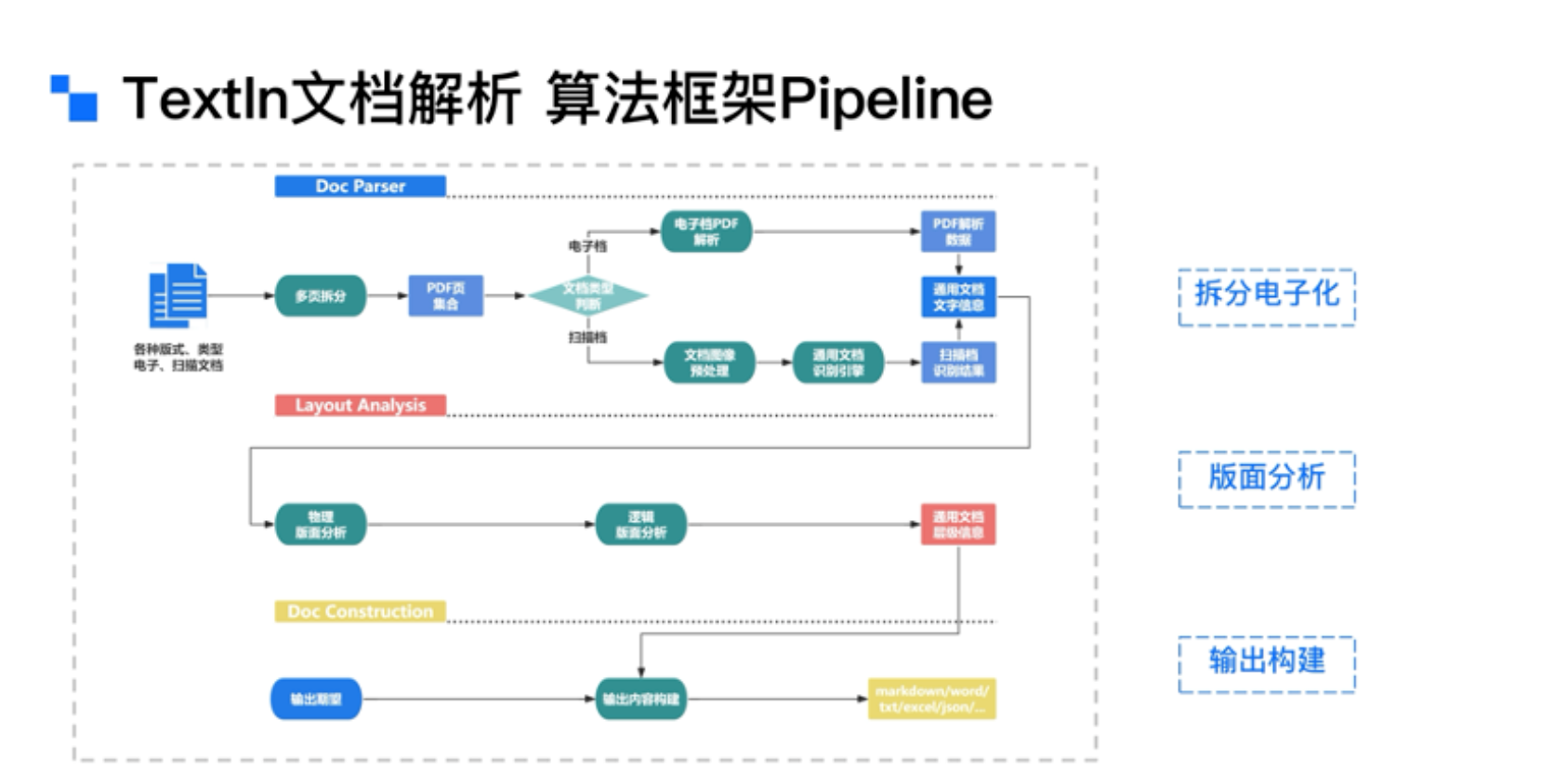

TextIn的文档解析技术,正是专为RAG应用量身打造的“知识抽取前置器”。它要解决的问题并不只是OCR(文字识别),而是更进一步的语义重建:

重构阅读顺序:多栏排版、跨页内容、嵌入图表,该先读哪段、后读哪句,决定了上下文是否连贯。

精准结构标注:这是一段正文,还是子标题?这是一张表格,还是排版的对齐巧合?错一环,信息全乱。

多模态还原:图文混排、公式嵌入、印章覆盖,在保持版面还原度的同时提取语义,是工业级解析的底线。

最终,TextIn将复杂文档转化为结构清晰、语义明确的标准化格式,如Markdown或JSON,确保信息在传递给大模型之前已具备良好的可读性与解析性。这一过程不仅提升了大模型对企业知识的理解能力,也为后续的语义检索与生成提供了坚实的数据基础。

02 | 向量化:打破通用模型的语义偏差

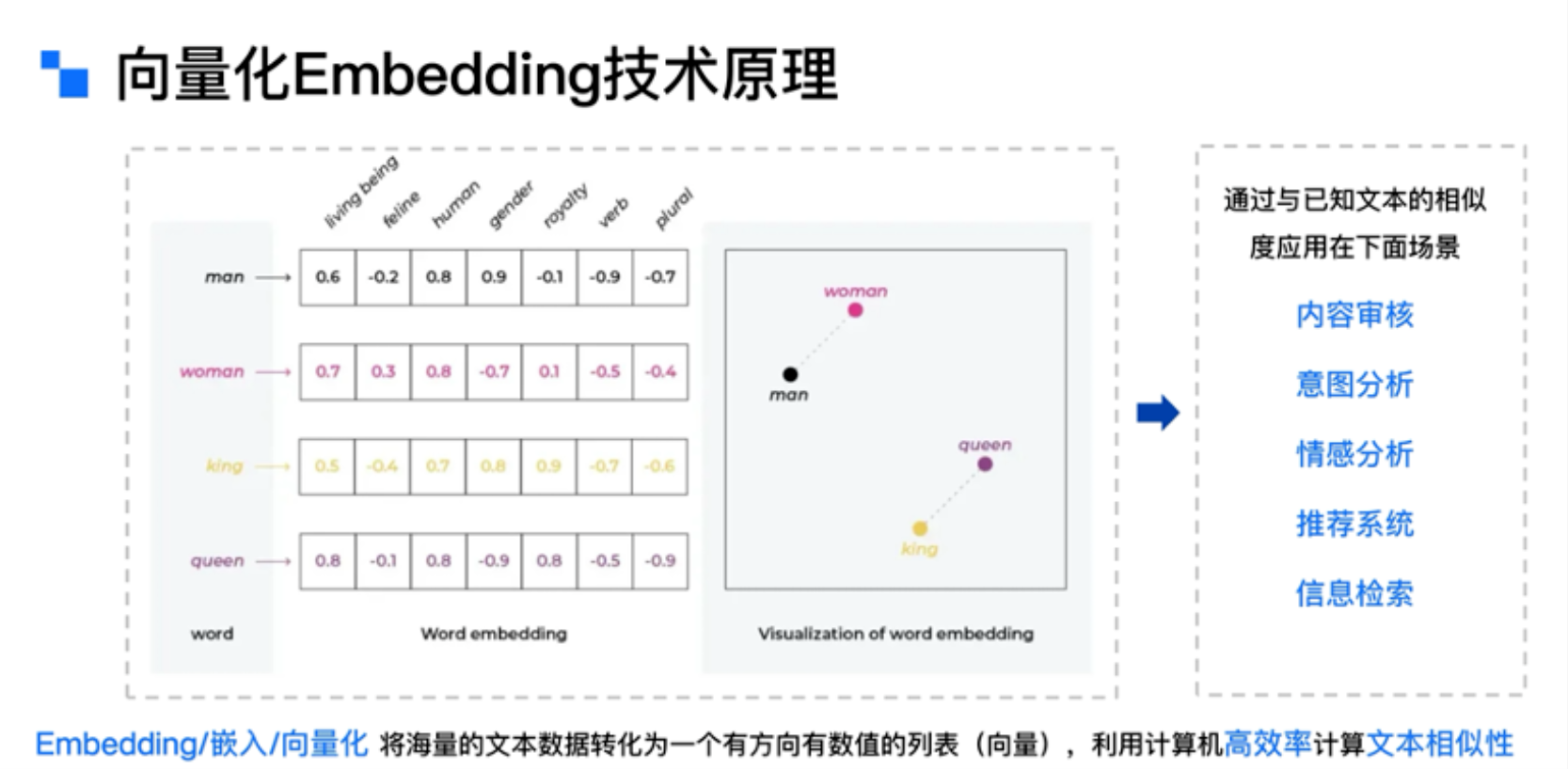

RAG中还有一个极容易被忽略的核心环节——向量化。RAG之“R”(检索),本质是计算问题与文档之间的“语义相似度”。那么问题来了:你把文档解析好了,模型如何快速在几十万篇文档中精准匹配出你要的信息?

答案是——将文本转化为向量,用数学距离衡量语义距离。这要求我们使用高质量的文本嵌入模型(Embedding Model),并合理设置分块策略、向量维度、检索索引等技术细节。

TextIn团队采用多尺度训练策略(Multi-Resolution Learning),在保证语义密度的前提下压缩向量维度,优化检索效率。不同任务对文本长度的需求不同,小说类内容可以分大段处理,合同时每个条款都要精读分块。这背后的尺度设计,决定了RAG能否在性能与准确率之间取得最佳平衡。

此外,TextIn还支持领域定制的嵌入模型训练,确保在金融、法律、工业等专业领域,不被“通用模型”带偏,真正理解专有术语与行业上下文。

03 | RAG应用底层支持:文档解析+向量化

TextIn围绕RAG的核心流程,聚焦两个关键底座能力进行了系统性重构:一是文档解析,引擎能够应对扫描件、多栏排版、图文混排等复杂文档场景,将知识以结构化、模型友好的形式精准还原;二是向量化技术,结合多尺度语义建模和领域定制嵌入,显著提升了语义检索的聚焦度与准确率。

文档解析,让知识“可以被用”;向量化,让检索“找到想要的”——这两步走稳了,RAG才真正有价值。